AESIA, la Agencia Española de Supervisión de Inteligencia Artificial

Han transcurrido ya más de cinco meses desde que, el día 2 de septiembre de 2023, se publicaron en el BOE los estatutos de la Agencia Española de Supervisión de Inteligencia Artificial (AESIA), creada por el Gobierno español para supervisar el uso de la IA en España. La agencia se creó en cumplimiento de la Ley de Presupuestos Generales del Estado para el año 2022, la Ley de fomento del ecosistema de las empresas emergentes y la Propuesta de Reglamento del Parlamento Europeo y del Consejo por el que se establecen normas armonizadas en materia de Inteligencia Artificial (Ley de Inteligencia Artificial).

AESIA tiene las siguientes funciones:

- Supervisar la aplicación de la Ley de Inteligencia Artificial en España.

- Coordinar las actividades de los Estados miembros en materia de IA.

- Actuar como punto de contacto único para la Comisión Europea en materia de IA.

- Representar a España en el Comité Europeo de Inteligencia Artificial.

AESIA es también la encargada de supervisar el uso de la IA en España en cumplimiento de otras normas nacionales e internacionales.

La polémica de la sede

La creación de AESIA ha estado rodeada de polémica desde su nacimiento. En el proceso de selección de su sede, dieciséis provincias presentaron candidatura. La propuesta seleccionada fue la de La Coruña, con el edificio de La Terraza, un palacete de más de cien años que ha pasado por diferentes destinos a lo largo de su existencia. A principios de 2023 se presentó un recurso contra esta decisión ante el Tribunal Supremo, que fue desestimado a finales de año.

Normativa de la UE

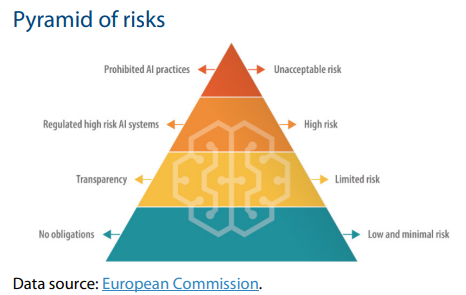

La nueva normativa establece obligaciones para proveedores y usuarios en función del nivel de riesgo de la IA. Aunque muchos sistemas de IA plantean un riesgo mínimo, es necesario evaluarlos todos.

Riesgo inaceptable

Los sistemas de IA de riesgo inaceptable son los que se consideran una amenaza para las personas y serán prohibidos. Incluyen:

- manipulación cognitiva del comportamiento de personas o grupos vulnerables específicos: por ejemplo, juguetes activados por voz que fomentan comportamientos peligrosos en los niños

- puntuación social: clasificación de personas en función de su comportamiento, estatus socioeconómico o características personales

- sistemas de identificación biométrica en tiempo real y a distancia, como el reconocimiento facial.

Aunque existen algunas excepciones a esta calificación. Por ejemplo, los sistemas de identificación biométrica a distancia “a posteriori”, en los que la identificación se produce tras un retraso significativo, se permitirán para perseguir delitos graves y sólo cuando haya previa aprobación judicial.

Alto riesgo

Los sistemas de IA que afecten negativamente a la seguridad o a los derechos fundamentales se considerarán de alto riesgo y se dividirán en dos categorías.

- Los sistemas de IA que se utilicen en productos sujetos a la legislación de la UE sobre seguridad de los productos. Esto incluye juguetes, aviación, automóviles, dispositivos médicos y ascensores.

- Los sistemas de IA pertenecientes a ocho ámbitos específicos que deberán registrarse en una base de datos de la UE:

- identificación biométrica y categorización de personas físicas

- gestión y explotación de infraestructuras críticas

- educación y formación profesional

- empleo, gestión de trabajadores y acceso al autoempleo

- acceso y disfrute de servicios privados esenciales y servicios y prestaciones públicas

- aplicación de la ley

- gestión de la migración, el asilo y el control de fronteras

- asistencia en la interpretación jurídica y aplicación de la ley.

Todos los sistemas de IA de alto riesgo serán evaluados antes de su comercialización y a lo largo de su ciclo de vida.

IA generativa

La IA generativa, como ChatGPT, tendría que cumplir requisitos de transparencia:

- revelar que el contenido ha sido generado por IA

- diseñar el modelo para evitar que genere contenidos ilegales

- publicar resúmenes de los datos protegidos por derechos de autor utilizados para el entrenamiento

Riesgo limitado

Los sistemas de IA de riesgo limitado deben cumplir unos requisitos mínimos de transparencia que permitan a los usuarios tomar decisiones con conocimiento de causa. Tras interactuar con las aplicaciones, el usuario puede decidir si desea seguir utilizándolas. Los usuarios deben ser conscientes de cuándo están interactuando con la IA. Esto incluye los sistemas de IA que generan o manipulan contenidos de imagen, audio o vídeo (por ejemplo, deepfakes).