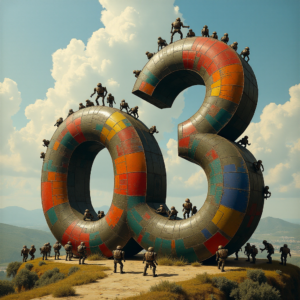

Stable Diffusion 3.0: la IA de texto a imagen por fin aprende a escribir.

En el ámbito de la IA generativa de texto a imagen, Stability AI ha presentado Stable Diffusion 3.0. Este nuevo modelo tiene como objetivo ofrecer mejor calidad de imagen, rendimiento mejorado y un gran salto en las capacidades de tipografía. ¡Stable Diffusion ha aprendido a escribir! Adiós a los garabatos ilegibles en imágenes perfectamente realistas.

Novedades técnicas: transformador de difusión y flujos de normalización continua

Stable Diffusion 3.0 se construye sobre una nueva arquitectura, el transformador de difusión. Esta arquitectura, similar a la utilizada en el modelo Sora de OpenAI, busca a revolucionar la generación de imágenes. Los transformadores de difusión reemplazan el backbone U-Net con un transformador que opera en parches de imágenes latentes. Este nuevo enfoque permite un uso más eficiente de la computación y supera a otros métodos de generación de imágenes por difusión.

Una segunda novedad, el modelado de flujo, es un nuevo método para entrenar flujos de normalización continua (Continuous Normalizing Flows, CNF) para modelar distribuciones de datos complejas. Conduce a un entrenamiento más rápido, una muestra más eficiente y un mejor rendimiento en comparación con el sistema de trayectorias de difusión.

Gracias a estas mejoras, Stable Diffusion 3.0 puede manejar oraciones completas de manera coherente y mantener un estilo consistente. Esto supone un gran avance con respecto a sus modelos anteriores, que tenían dificultades para escribir correctamente.

¿Competencia para Sora?

No es el único frente en el que Stability AI está trabajando. En los últimos meses se han anunciado mejoras en la generación de modelos 3D (Stable 3D) y vídeos (Stable Video Diffusion, SVD), aunque está por verse si su calidad puede convertirla en un serio competidor de Sora, la nueva herramienta de OpenAI que promete la generación de vídeo basada en modelos físicos.